7天8卡训练32种语言,深度学习打造机器翻译“天才”

机器翻译对于信息时代下海量信息的捕获无疑具有重要作用,事实上,人们对于机器翻译的需求也与日俱增,比如不同语言间交流信息、海内外文学作品的专业翻译等等。一个理想的模型是一个统一的具备多种语言能力的模型,在遇到新的语言时,临时少量学习即可达到很流利的语言水平,EMNLP 2020的多语言翻译新范式mRASP就成功实现了这一理想模型。

机器翻译界的“赵元任”

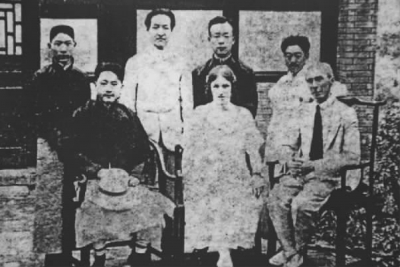

1920 年哲学家罗素来中国各地访问,陪同翻译的是当时清华大学语言学家赵元任。赵元任极富语言天才,当时已经会说保定话、常州话、福州话、南京话等多地方言和英语。他在陪同罗素从上海到长沙的船上跟同船的经济学家杨瑞六学长沙话,船到长沙靠岸,赵元任已经能把罗素的演讲和俚语翻译成长沙话了。神经网络翻译能否成为「机器翻译界的赵元任」呢?即创造一个统一的具备多种语言能力的模型,在遇到新的语言时,临时少量学习即可达到很流利的语言水平。

赵元任(后排左二)与罗素(前排右一)

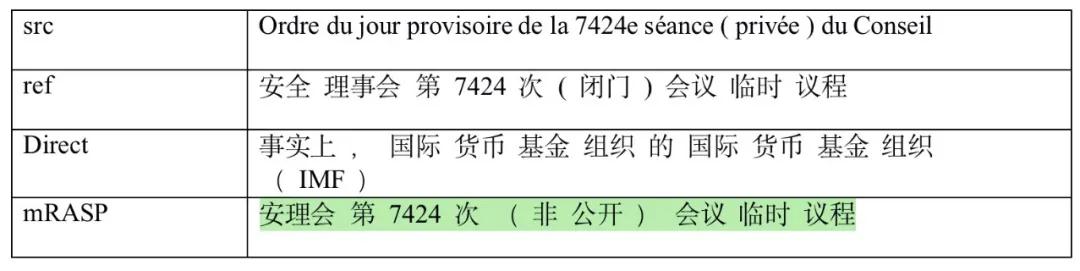

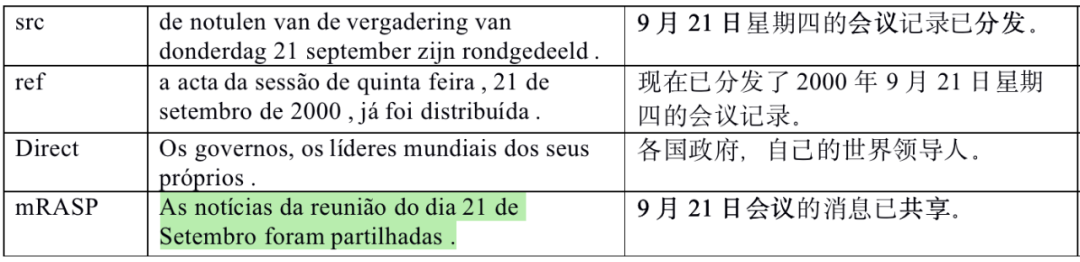

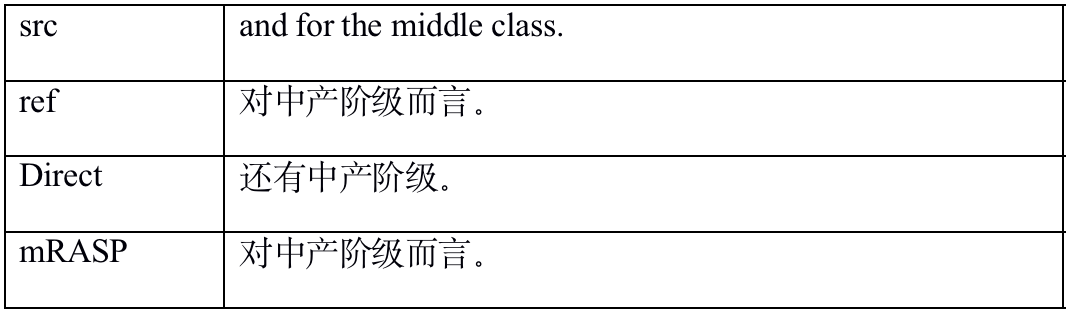

EMNLP 2020新鲜出炉的多语言翻译新范式 (mRASP),其核心思想是打造「机器翻译界的赵元任模型」,通过预训练技术再在具体语种上微调即可达到领先的翻译效果,其在32个语种上预训练出的统一模型在47个翻译测试集上取得了全面显著地提升。

7天8卡快速训练

字节跳动已应用

mRASP主要针对机器翻译任务而设计,它有三个应用优势:

打破了资源场景的限制。不论平行双语资源高低都能有所提升。在低资源语言中,mRASP的表现令人惊喜,极端情况下,只需要一万句训练数据,通过10分钟微调训练,就能得到一个还不错的翻译系统。

打破了语种数量的限制。任何语言的翻译,无论是孟加拉语到古吉拉特语还是印地语到菲利宾语,只要是地球上的语言,mRASP都可以直接拿来微调,并且效果可期。

资源消耗低。相比于上百张卡的「军备竞赛」预训练玩法,mRASP更平民,仅需要8卡训练一周就可以得到。简单来说,我们可以把mRASP理解为机器翻译领域的轻量级BERT,只要是机器翻译任务,任何场景或者语言,拿来用用,都有可能出现小惊喜!

论文作者表示已经在字节跳动研发的火山翻译系统上使用了这项技术,得到了实际业务的检验。作者还公布了研究数据、代码和预训练模型,参见下方GitHub地址。

Github 地址:https://github.com/linzehui/mRASP

论文地址:https://arxiv.org/abs/2010.03142

定制RTX30液冷服务器

稳定加速训练神经网络

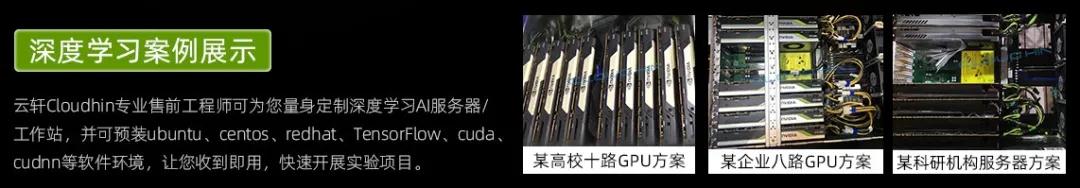

Cloudhin®云轩专业售前工程师可为您量身定制深度学习AI服务器/工作站,并可预装ubuntu、centos、redhat、TensorFlow、cuda、cudnn等软件环境,让您收到即用,快速开展实验项目。

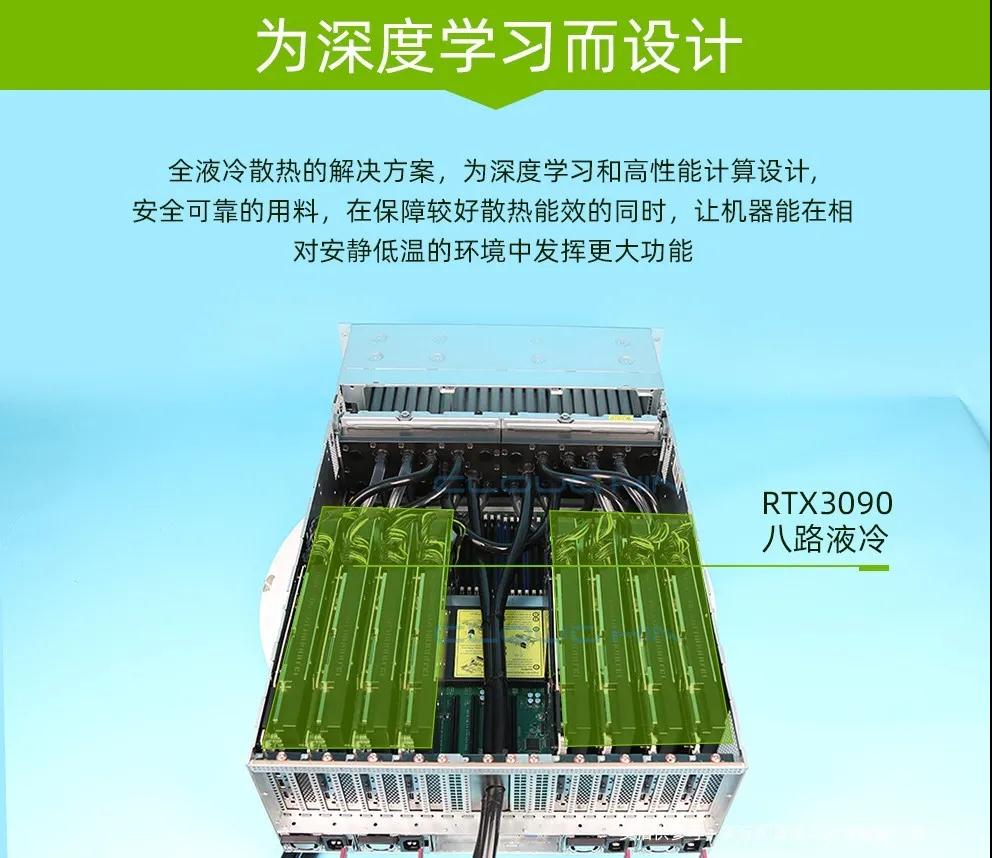

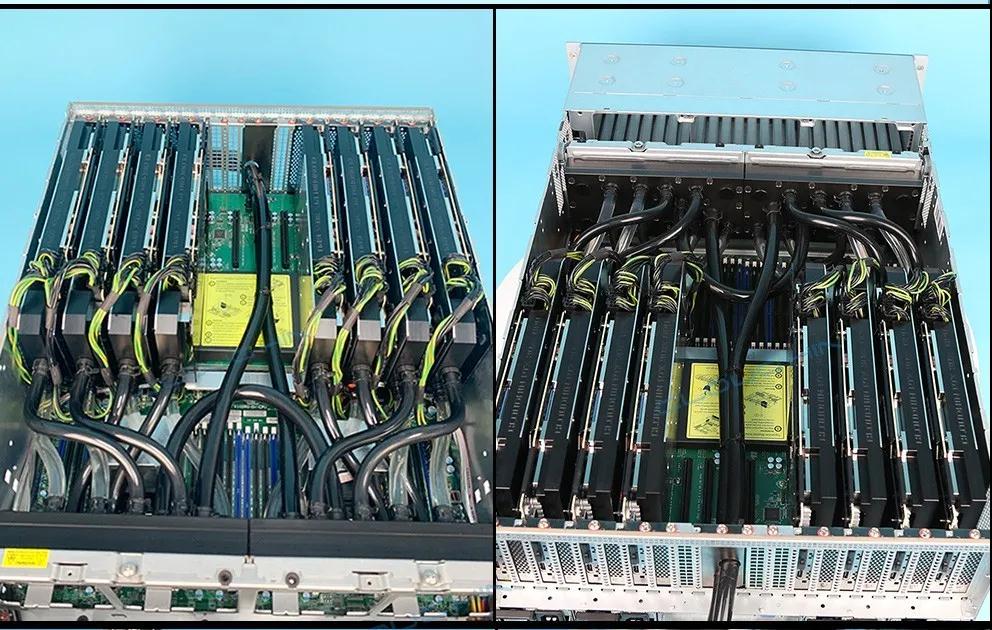

针对深度学习机器发热量大、散热难、噪音刺耳的问题,Cloudhin®云轩研发组排除重重苦难,历时数百个小时的打磨迭代和反复测试,率先全国推出8路RTX 30机架式GPU液冷服务器!有效解决RTX 30系列GPU多路并行计算散热以及背部GDDR6X显存高温问题。大幅提升RTX 30系列并行计算功率密度,具有更高性能、更低能耗、更低成本、更为可靠的特点。

通过定制化高质量液冷系统使GPU和处理器可超频工作,进而获得更强性能。每个服务器机架的硬件包装密度可最大化,即使在连续负载下,也可调出硬件的最佳性能而无需担心任何散热问题。广泛应用于3D渲染、深度学习、3D CAD、科学计算等领域。

专业勤修,锐意进取。云轩技术工程师毕业于NVIDIA深度学习研究所,丰富经验,值得信赖。

如果您有合作需求或宝贵建议,欢迎来信。

邮箱:hezuo@kuanfans.com

合作热线:021-5415 5559