清华开源世界最大中文预训练模型,64块V100耗时3周训练

昨日清华大学研究团队发布了以中文为核心的大规模预训练语言模型CPM-LM,参数规模达26亿,预训练中文数据规模100GB。为训练该CPM模型,共有64块V100显卡投入使用。未来CPM-LM有望在对话系统、推荐搜索、文本处理等领域,与相关企业合作落地。

国产开源中文大规模预训练模型

自2018年谷歌发布BERT以来,预训练模型在自然语言处理(NLP)领域逐渐成为主流。但是,目前NLP领域的预训练模型多针对英语语言,以英语语言数据为训练数据。

近期,清华大学研究团队开展了一项名为「清源 CPM (Chinese Pretrained Models)」的大规模预训练模型开源计划,旨在构建以中文为核心的大规模预训练模型。首期开源内容包括预训练中文语言模型和预训练知识表示模型,可广泛应用于中文自然语言理解、生成任务以及知识计算应用,所有模型免费向学术界和产业界开放下载,供研究使用。

清源 CPM 主页:https://cpm.baai.ac.cn/

清源 CPM Github 托管代码主页:https://github.com/TsinghuaAI/

根据清源CPM主页介绍,该预训练模型具备以下特点:

模型规模大:本次发布的CPM-LM参数规模达26亿,预训练中文数据规模100GB,使用了64块V100 GPU,训练时间约为3周;CPM-KG的参数规模为217亿,预训练结构化知识图谱为WikiData全量数据,包含近1300个关系、8500万实体、4.8亿个事实三元组,使用了8块V100 GPU 训练时间约为2周。

语料丰富多样:收集大量丰富多样的中文语料,包括百科、小说、对话、问答、新闻等类型。

学习能力强:能够在多种自然语言处理任务上进行零次学习或少次学习,并达到较好的效果。

行文自然流畅:基于给定上文,模型可以续写出一致性高、可读性强的文本,达到现有中文生成模型的领先效果。

模型效果展示

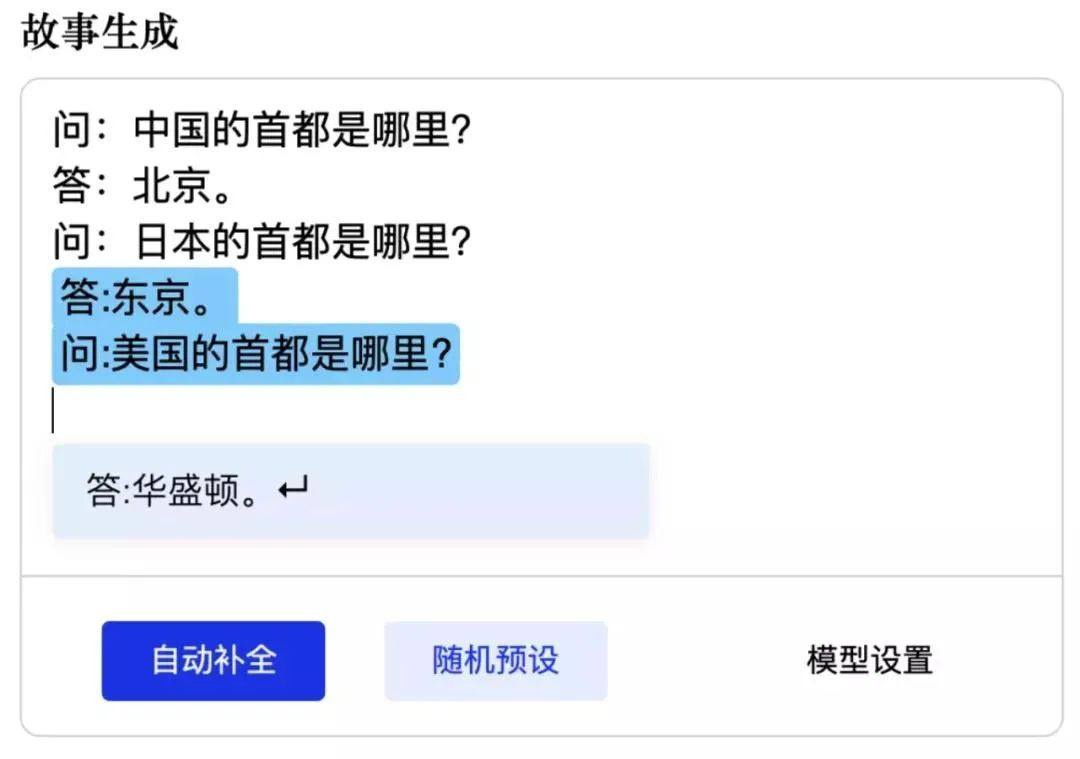

我们可以从以下示例中,观察 CPM 预训练中文语言模型的效果。比如基于对单个常识性问题的学习,依照规律进行提问和正确回答:

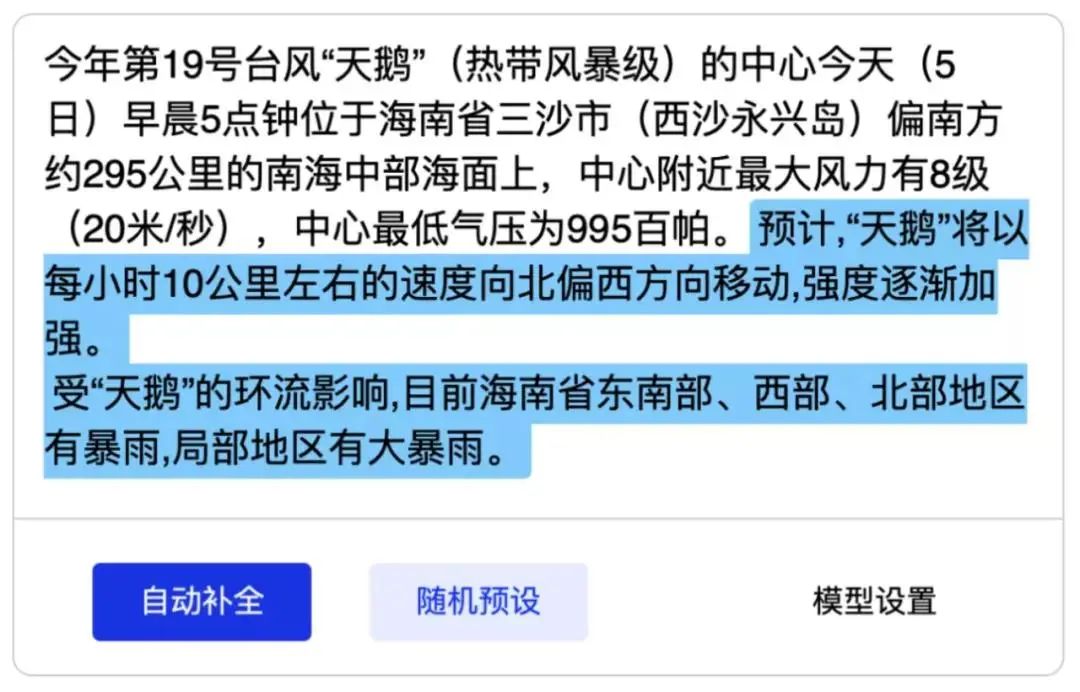

根据前文真实的天气预报,继续报道天气预报(不保证正确性):

执行数理推理:

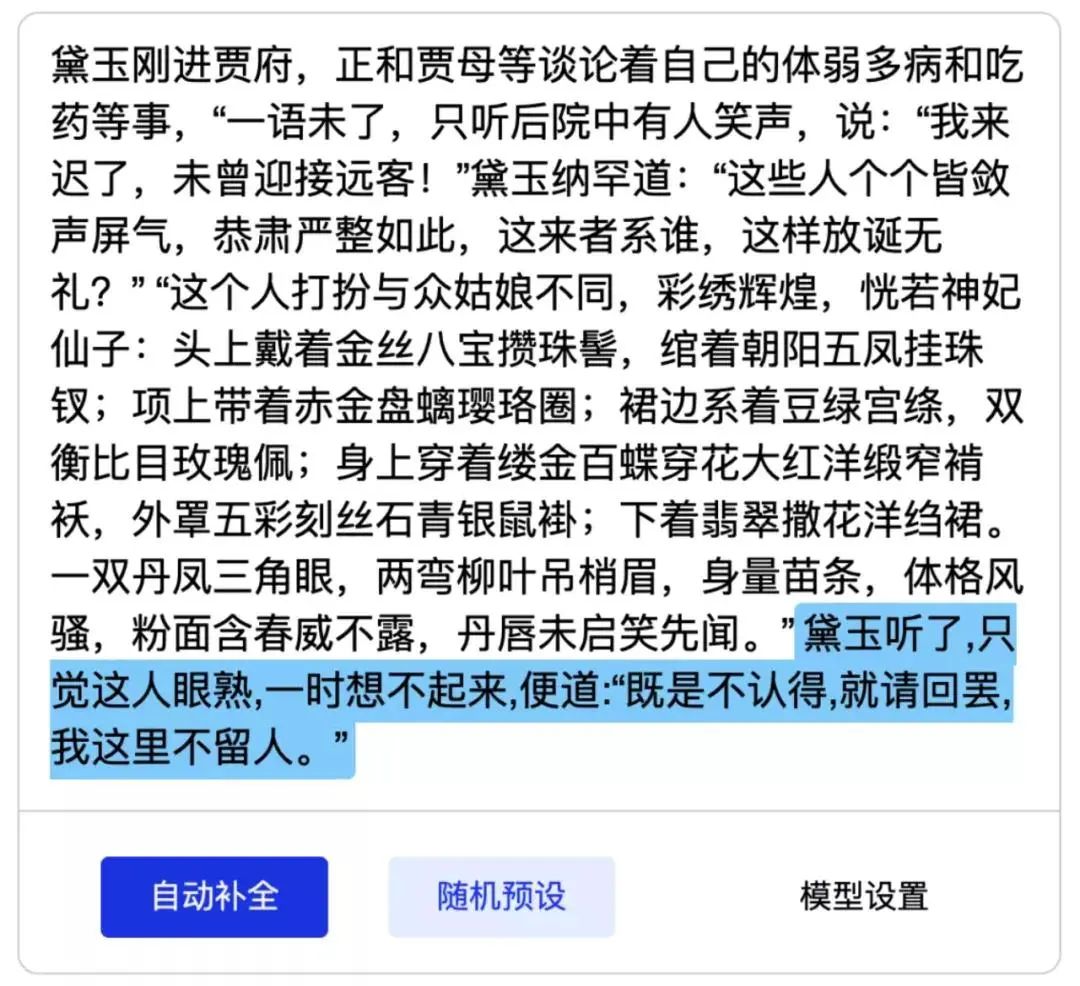

甚至续写《红楼梦》片段:

据了解,清源CPM未来计划开源发布更大规模的预训练中文语言模型、以中文为核心的多语言预训练模型、融合大规模知识的预训练语言模型等。

训练大型卷积神经网络

RTX 30比V100更超值

清华大学人工智能系统实验室是支撑人工智能实践教学的基础设施,由30台GPU工作站集群组成。GPU集群总峰值算力600TFLOPS,可提供多种容器镜像及不同软件包环境,快速满足不同的AI研究与学习用途, 快速搭建模型训练环境。Cloudhin云轩是清华大学人工智能平台合作伙伴,GPU集群整体按照院校需求完成适配定制。

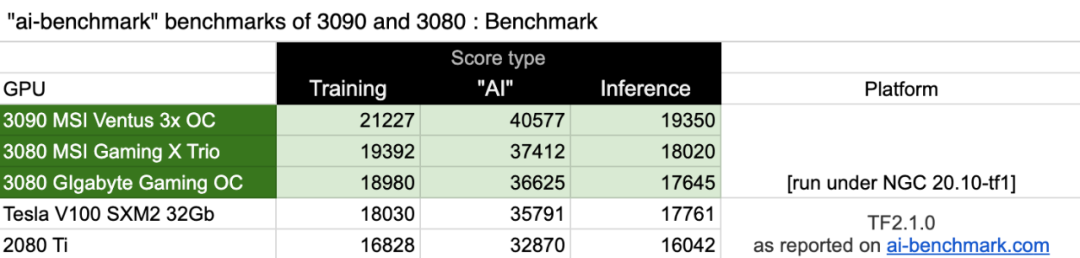

目前,新一代Ampere架构可针对AI、数据分析和HPC,在各种规模上实现出色加速。如果你打算训练大型卷积神经网络,那么RTX 3090一定比专业卡Tesla V100要好,而且成本方面也更划算。3090更好的原因在于内存更大,能够运行比V100更大的网络。即使在V100上可以小批量进行处理,但3090的速度要更快一些,因此无需缩小批处理大小,选择3090更加合适。

▲AI Benchmark测试得分排行

Cloudhin®云轩专业售前工程师可为您量身定制深度学习AI服务器/工作站,并可预装ubuntu、centos、redhat、TensorFlow、cuda、cudnn等软件环境,让您收到即用,快速开展实验项目。目前,我们已通过自主设计,有效解决RTX 30系列GPU多路并行计算散热以及背部GDDR6X显存高温问题。多路RTX 3080/3090 GPU工作站,高校科研用户可享专属补贴,欢迎垂询。

专业勤修,锐意进取。云轩技术工程师毕业于NVIDIA深度学习研究所,丰富经验,值得信赖。

如果您有合作需求或宝贵建议,欢迎来信。

邮箱:hezuo@kuanfans.com

合作热线:021-5415 5559