【小巧强劲】PCIE版安培计算卡亮相,更适合高性能计算服务器定制

NVIDIA A100 Tensor Core GPU可针对AI、数据分析和高性能计算(HPC),在各种规模上实现出色的加速,应对极其严峻的计算挑战。前不久,基于标准PCIe形态的A100计算卡也终于登场了,更适合主流标准服务器。我们详细对比了两种不同形态的A100,一起来看看区别吧。

NVIDIA A100 GPU性能对比

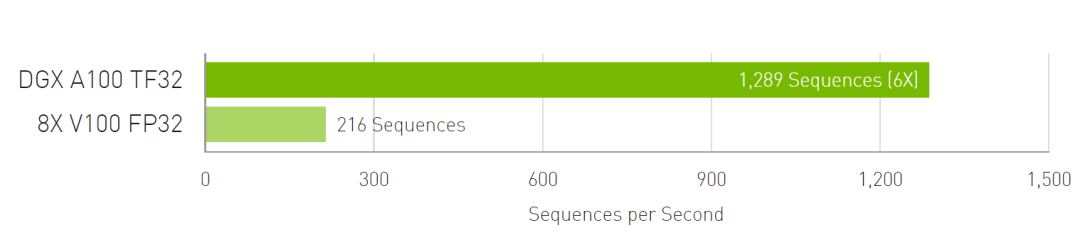

我们自然语音处理用PyTorch的BERT预训练吞吐量包括(2/3)阶段1和(1/3)阶段2。阶段1序列长度=128,阶段2序列长度=512,做一下训练测试比对。

硬件环境:采用DGX-1 8块 V100(32G)使用FP32精度计算 VS DGX A100 8块A100(40G)使用TF32精度计算。

训练测试最终结果可以看到,A100采用TF32进行训练,最高可提供6倍性能提升。

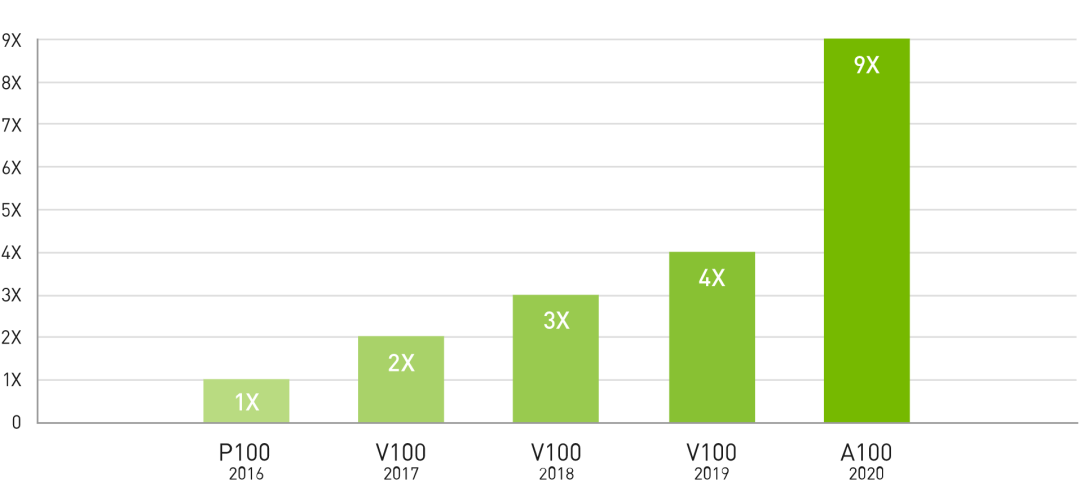

另外我们拿HPC高性能应用程序,测试硬件采用双CPU,4卡P100/V100 16G/V100 32G / V100S 32G /A100 ,做吞吐量测试。

技术总结

目前在高性能计算中大量使用GPU去做计算,这些在物理化学、分子动力学、冷冻电镜、气象、流体仿真、药物筛选等领域,随着数据的递增对算力的精度的准确度提高,不得不使得我们的硬件也要做新的革新,此次新的Ampere 架构的A100新技术的引入,让我们的运算吞吐量实现了更高的提升。

PCIe版本A100加速卡已发布

从P100时代开始,NVIDIA就会发布两种不同形态的顶级加速卡,一种形态是NVIDIA自家开发出的SXM,需要配合自家的HGX主板使用,价格较为昂贵,但是可以提高整体的集成度,在一套系统里面集成更多的加速卡。另一种形态就是传统的Add-in-Card,用的是PCIe的接口,可以装载到传统系统中使用。

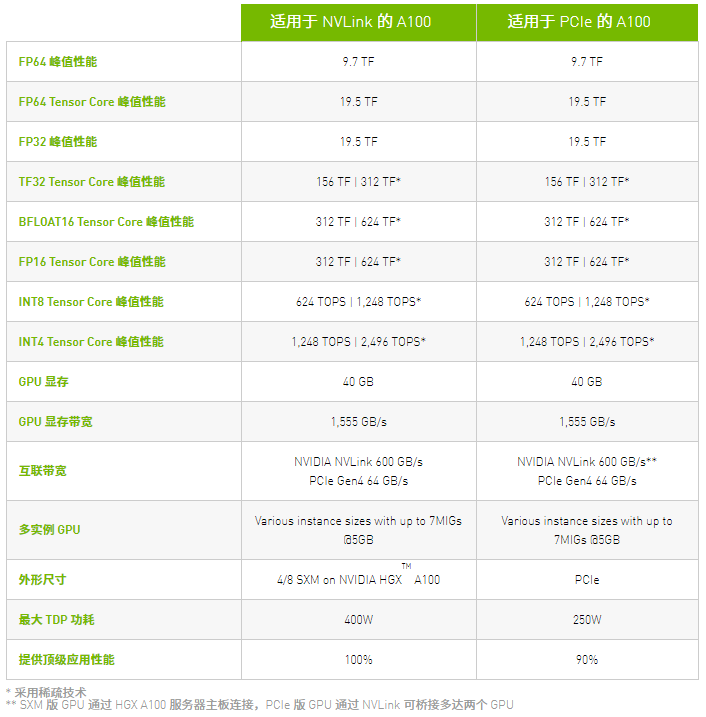

PCIe A100仍然基于GA100核心,规模保持不变,还是台积电7nm工艺、826平方毫米、542亿个晶体管,提供6912个FP32 CUDA核心,最高加速频率也是1.41GHz,因此峰值性能相同:单精度19.5TFlops、双精度9.7TFlops、INT8推理1248Tops、INT8张量624Tops、FP16张量312TFlops、FP32张量156TFlops、FP32训练312TFlops、FP64高性能计算19.5TFlops。

NVIDIA宣称,相比于上代Volta伏特架构的V100计算卡,INT8推理性能、FP32训练性能都实现了20倍的提升,FP64高性能计算也提升了2.5倍,是历史上进步最大的一次。

▲PCIe 版 NVIDIA A100

PCIe形态的A100使用了完全的被动散热设计,很明显是要服务器系统内部的暴力风扇来辅助散热的,采用被动散热设计也有利于安排系统内部的风道,达成更为高效的散热。

由于它的散热空间有限,NVIDIA将其功耗限制在250W,SXM4版本则为400W,PCIe版本的A100在持续性能输出上面是不如SXM4版本的,官方给出了90%的相对性能数据,也算不上有太多的损失。

另外一点不同就是多卡并联,SMX4版本支持最多八块并行,PCIe则只能两块并行,NVLink互连总线显然做了精简,但具体未披露,可能从12条砍半至6条。

最后给大家分享一下A100在2种平台上技术指标:

Cloudhin®云轩是英伟达战略合作伙伴

专业为AI、数据科学和科学计算加速

Cloudhin®云轩专注Deep learning和高性能计算服务器定制,针对主要深度学习框架(如TensorFlow、Caffe 2、Theano或Torch)进行了优化和设置,在桌面上即可提供强大的深度学习功能。

Cloudhin®云轩GS4288-P4采用Intel C612最高速芯片组,性能稳定,把握十足。其支持两颗E5-2600 v4/v3(24核48线程),内存最大支持3TB内存。

最高可搭载8个NVIDIA图形处理器,RTX 2080/S/TI、RTX TITAN/V、TESLA T4/P100/V100,均支持按需定制。它可以让你轻松应对分子动力学模拟、排序,生命科学与医疗分析、石油天然气勘探、GPU虚拟化服务器,是复杂模型计算的理想选择。

专业勤修,锐意进取。云轩技术工程师毕业于NVIDIA深度学习研究所,丰富经验,值得信赖。更多定制方案请联系客服,我们将实时响应您的定制需求。